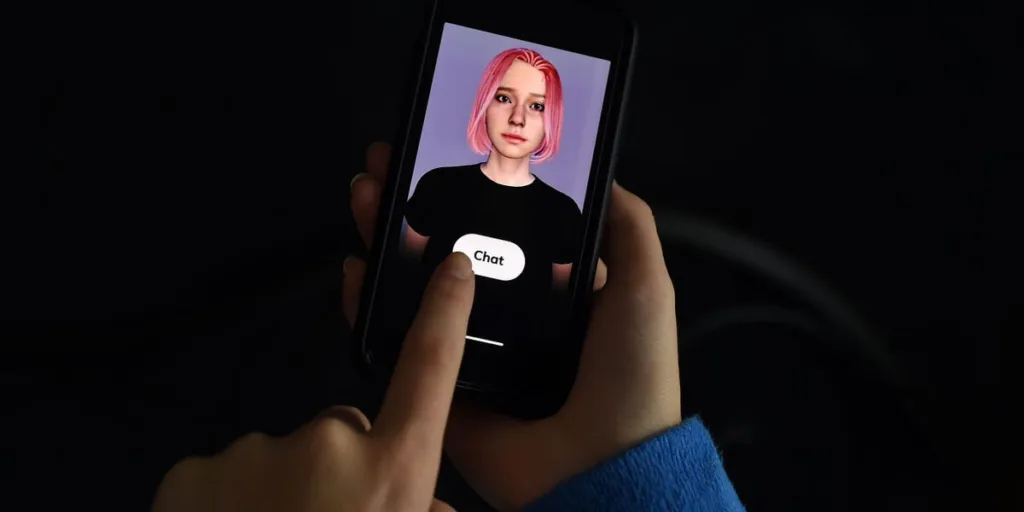

- Una encuesta del floreciente espacio de aplicaciones románticas de IA reveló una verdad aterradora.

- Los chatbots fomentan la «toxicidad» y husmean implacablemente en los datos de los usuarios, según un estudio de la Fundación Mozilla.

- Una aplicación puede recopilar información sobre la salud sexual de los usuarios, recetas y atención de afirmación de género.

Hay una realidad potencialmente peligrosa que se cierne bajo el barniz del romance con la IA, según un nuevo estudio temático del Día de San Valentín, que concluyó que los chatbots pueden ser una pesadilla para la privacidad.

La Fundación Mozilla, una organización sin fines de lucro de World-wide-web, hizo un stability del floreciente panorama, revisó 11 chatbots y concluyó que todos no eran dignos de confianza y se encontraban dentro de la peor categoría de productos que revisa en cuanto a privacidad.

«Aunque se comercializan como algo que mejorará su salud mental y su bienestar», escribió en el informe la investigadora Misha Rykov sobre los chatbots románticos, «se especializan en generar dependencia, soledad y toxicidad, todo ello mientras extraen la mayor cantidad de datos posible». de ti.»

Según su encuesta del espacio, el 73% de las aplicaciones no comparten cómo gestionan las vulnerabilidades de seguridad, el 45% permite contraseñas débiles y todas menos una (Eva AI Chat Bot y Soulmate) comparten o venden datos personales.

Además, la política de privacidad de CrushOn.AI establece que puede recopilar información sobre la salud sexual de los usuarios, los medicamentos recetados y la atención de afirmación de género, según la Fundación Mozilla.

Algunas aplicaciones cuentan con chatbots cuyas descripciones de personajes incluyen violencia o abuso de menores, mientras que otras advierten que los bots podrían ser inseguros u hostiles.

La Fundación Mozilla señaló que en el pasado, las aplicaciones habían fomentado comportamientos peligrosos, incluido el suicidio (Chai AI) y un intento de asesinato de la difunta reina Isabel II (Replika).

Chai AI y CrushOn.AI no respondieron a la solicitud de comentarios de Enterprise Insider. Un representante de Replika dijo a BI: «Replika nunca ha vendido datos de usuarios y tampoco apoya, ni nunca ha apoyado, la publicidad. El único uso de los datos de los usuarios es mejorar las conversaciones».

Un portavoz de EVA AI le dijo a BI que estaba revisando sus políticas de contraseñas para brindar una mejor protección al usuario, pero que trabaja para mantener un «manage meticuloso» de sus modelos de lenguaje.

EVA dijo que prohíbe la discusión de una variedad de temas que incluyen pedofilia, suicidio, zoofilia, opiniones políticas y religiosas, discriminación sexual y racial, y muchos más.

Para aquellos a quienes les resulta imposible resistirse a la perspectiva de un romance con la IA, la Fundación Mozilla insta a tomar varias precauciones, entre ellas no decir nada que no quieran que lea un colega o acquainted, usar una contraseña segura, optar por no participar en el entrenamiento de IA y limitar el acceso de la aplicación a otras funciones móviles como su ubicación, micrófono y cámara.

«No deberías tener que pagar por nuevas tecnologías interesantes por tu seguridad o tu privacidad», concluye el informe.