Fox Corp. causó conmoción en los círculos de los medios el martes cuando anunció que lanzaría «Verify», una nueva herramienta basada en blockchain para verificar la autenticidad de los medios digitales en la era de la IA.

El proyecto aborda un par de problemas cada vez más molestos: la IA está facilitando que surja contenido «deepfake» que engañe a los lectores, y los editores descubren con frecuencia que su contenido se ha utilizado para entrenar modelos de IA sin permiso.

Una opinión cínica podría ser que todo esto es sólo un gran movimiento de relaciones públicas. Combinar «IA» y «Blockchain» en un guiso de palabras de moda para ayudar a generar «confianza en las noticias» parece un excelente product de prensa, especialmente si eres un conglomerado de medios envejecido con problemas de credibilidad. todos hemos visto Sucesión¿No es así?

Pero dejemos de lado la ironía por un momento y tomemos en serio a Fox y su nueva herramienta. En el lado de la falsificación profunda, Fox dice que las personas pueden cargar URL e imágenes en el sistema Validate para determinar si son auténticas, lo que significa que un editor las ha agregado a la foundation de datos de Validate. En lo que respecta a las licencias, las empresas de inteligencia synthetic pueden utilizar la base de datos Confirm para acceder (y pagar) contenido de manera suitable.

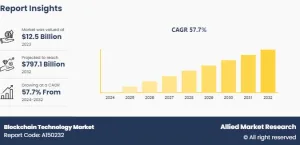

Blockchain Inventive Labs, el brazo tecnológico interno de Fox, se asoció con Polygon, la cadena de bloques de bajo costo y alto rendimiento que funciona sobre la extensa crimson Ethereum, para impulsar las cosas detrás de escena. Agregar contenido nuevo a Confirm significa esencialmente agregar una entrada a una foundation de datos en la cadena de bloques Polygon, donde se almacenan sus metadatos y otra información.

A diferencia de muchos otros experimentos criptográficos, la vinculación de blockchain podría tener sentido esta vez: Polygon proporciona al contenido de Confirm un registro de auditoría inmutable y garantiza que los editores externos no necesiten confiar en Fox para administrar sus datos.

Validate en su estado precise se parece un poco a un verificador de bases de datos glorificado, una aplicación net uncomplicated que utiliza la tecnología de Polygon para realizar un seguimiento de imágenes y URL. Pero eso no significa que sea inútil, especialmente cuando se trata de ayudar a los editores tradicionales a negociar acuerdos de licencia en el mundo de los grandes modelos lingüísticos.

Seguimos adelante y subimos contenido a la aplicación internet de Verify para ver qué tan bien funciona en el uso diario, y no nos llevó mucho tiempo darnos cuenta de las limitaciones de la aplicación para el caso de uso del consumidor.

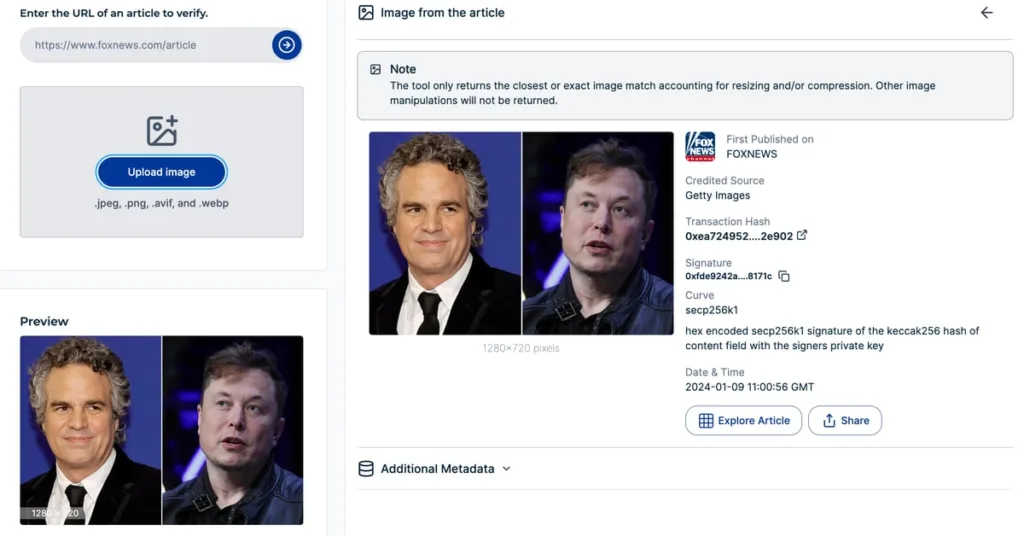

La aplicación Validate tiene un cuadro de entrada de texto para las URL. Cuando pegamos un artículo de Fox Information del martes sobre Elon Musk y las falsificaciones profundas (que aparecían de manera destacada en el sitio) y presionamos «enter», apareció un montón de información que atestiguaba la procedencia del artículo. Junto con un hash de transacción y una firma (datos para la transacción de la cadena de bloques Polygon que representa el contenido), la aplicación Verify también mostró los metadatos asociados al artículo, información de licencia y un conjunto de imágenes que aparecen en el contenido.

Luego descargamos y volvimos a cargar una de esas imágenes en la herramienta para ver si se podía verificar. Cuando lo hicimos, se nos mostraron datos similares a los que vimos cuando ingresamos la URL. (Cuando probamos otra imagen, también pudimos hacer clic en un enlace para ver otros artículos de Fox en los que se había utilizado la imagen. ¡Genial!)

Si bien Verify logró estas tareas simples como se anuncia, es difícil imaginar que muchas personas necesitarán «verificar» la fuente del contenido que obtuvieron directamente del sitio world-wide-web de Fox News.

En su documentación, Validate sugiere que un posible usuario del servicio podría ser una persona que encuentre un artículo en las redes sociales y quiera averiguar si proviene de una fuente putativa. Cuando ejecutamos Validate en este escenario del mundo genuine, nos encontramos con problemas.

Encontramos un funcionario Publicación de Fox Information sobre X (la plataforma anteriormente conocida como Twitter) que presenta el mismo artículo que verificamos originalmente y luego cargamos la versión X de la URL del artículo en Verify. Aunque al hacer clic en el enlace X se accede directamente a la misma página de Fox Information que revisamos originalmente, y Verify pudo obtener una vista previa del artículo, Validate no pudo decirnos si el artículo era auténtico esta vez. .

Luego tomamos una captura de pantalla de la imagen en miniatura de la publicación de Fox Information: una de las mismas imágenes de Fox que subimos la última vez. Esta vez, nos dijeron que la imagen no podía autenticarse. Resulta que si una imagen se manipula de alguna manera (lo que incluye miniaturas ligeramente recortadas o capturas de pantalla cuyas dimensiones no son exactamente correctas), la aplicación Validate se confundirá.

Algunas de estas deficiencias técnicas seguramente se solucionarán, pero hay problemas de ingeniería aún más complicados con los que Fox tendrá que lidiar si espera ayudar a los consumidores a descubrir el contenido generado por IA.

Incluso cuando Verify funciona como se anuncia, no puede decirle si el contenido fue generado por IA, solo que proviene de Fox (o de cualquier otra fuente que lo haya subido, suponiendo que otros editores usen Confirm en el futuro). Si el objetivo es ayudar a los consumidores a distinguir el contenido generado por IA del contenido humano, esto no ayuda. Incluso medios de noticias confiables como Sports activities Illustrated se han convertido envuelto en controversia para utilizar contenido generado por IA.

Luego está el problema de la apatía del usuario. A la gente no suele importarle mucho si lo que leen es cierto, como seguramente Fox sabe. Esto es especialmente cierto cuando las personas quiero que algo sea verdad.

Para que algo como Confirm sea útil para los consumidores, uno imagina que será necesario integrarlo directamente en las herramientas que las personas usan para ver contenido, como navegadores world wide web y plataformas de redes sociales. Se podría imaginar una especie de placa, al estilo notas comunitariasque aparece en el contenido que se ha agregado a la base de datos de Verify.

Se siente injusto criticar esta versión básica de Verify dado que Fox fue bastante proactivo al etiquetarla como beta. Fox tampoco se centra únicamente en los consumidores de medios en typical, como lo hemos hecho en nuestras pruebas.

El socio de Fox, Polygon, dijo en un comunicado de prensa compartido con CoinDesk que «Validate establece un puente técnico entre las empresas de medios y las plataformas de inteligencia artificial» y tiene características adicionales para ayudar a crear «nuevas oportunidades comerciales para los propietarios de contenido mediante el uso de contratos inteligentes para establecer condiciones programáticas para acceso al contenido.»

Si bien los detalles aquí son algo vagos, la notion parece ser que Confirm servirá como una especie de foundation de datos international para plataformas de inteligencia artificial que rastrean la internet en busca de contenido de noticias, proporcionando una manera para que las plataformas de inteligencia synthetic obtengan autenticidad y para que los editores controlen su contenido. detrás de restricciones de licencia y muros de pago.

Verify probablemente necesitaría la aceptación de una masa crítica de editores y empresas de inteligencia synthetic para que este tipo de cosas funcione Por ahora, la foundation de datos sólo incluye alrededor de 90.000 artículos de editoriales propiedad de Fox, incluidos Fox Information y Fox Athletics. La compañía también dice que ha abierto la puerta para que otros editores agreguen contenido a la base de datos Verify, y también ha abierto su código a aquellos que quieran crear nuevas plataformas basadas en su tecnología.

Incluso en su estado real, el caso de uso de licencia para Validate parece una plan sólida, particularmente a la luz de las espinosas cuestiones legales que los editores y las empresas de inteligencia synthetic están enfrentando actualmente.

En un expediente presentado recientemente demanda judicial Contra OpenAI y Microsoft, el New York Instances alegó que su contenido se utilizó sin permiso para entrenar modelos de IA. Verify podría proporcionar un marco estándar para que las empresas de IA accedan a contenidos en línea, dando así a los editores de noticias cierta ventaja en sus negociaciones con las empresas de IA.