Según el cofundador de Ethereum (ETH), Vitalik Buterin, el nuevo método de compresión de imágenes Token for Graphic Tokenizer (TiTok AI) puede codificar imágenes a un tamaño lo suficientemente grande como para agregarlas en la cadena.

En su cuenta de redes sociales Warpcast, Buterin calificó el método de compresión de imágenes como una nueva forma de «codificar una imagen de perfil». Continuó diciendo que si puede comprimir una imagen a 320 bits, lo que llamó «básicamente un hash», las imágenes serían lo suficientemente pequeñas como para ir en cadena para cada usuario.

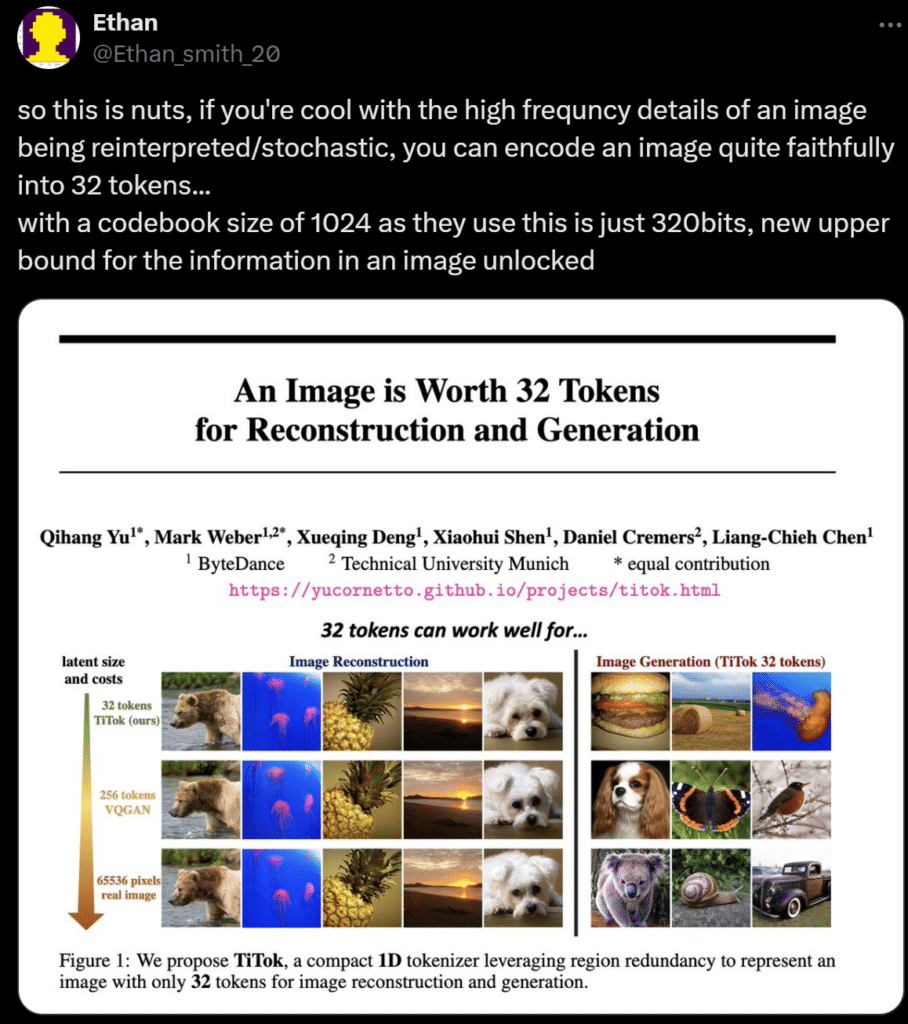

El cofundador de Ethereum se interesó en TiTok AI a partir de una publicación X realizada por un investigador de la plataforma generadora de imágenes de inteligencia artificial (IA) Leonardo AI.

El investigador, bajo el nombre de @Ethan_smith_20, explicó brevemente cómo el método podría ayudar a aquellos interesados en la reinterpretación de detalles de alta frecuencia dentro de imágenes para codificar con éxito imágenes complejas en 32 tokens.

La perspectiva de Buterin sugiere que el método podría facilitar significativamente a los desarrolladores y creadores la creación de imágenes de perfil y tokens no fungibles (NFT).

Resolver problemas anteriores de tokenización de imágenes

TiTok AI, desarrollado mediante un esfuerzo colaborativo de la empresa matriz de TikTok, ByteDance, y la Universidad de Munich, se describe como un marco innovador de tokenización unidimensional, que se diferencia significativamente de los métodos bidimensionales predominantes en uso.

Según un artículo de investigación sobre el método de tokenización de imágenes, la IA permite a TiTok comprimir imágenes renderizadas de 256 por 256 píxeles en «32 tokens distintos».

El documento señaló los problemas observados con los métodos anteriores de tokenización de imágenes, como VQGAN. Anteriormente, la tokenización de imágenes period posible, pero las estrategias se limitaban al uso de «cuadrículas latentes 2D con factores de reducción de resolución fijos».

La tokenización 2D no pudo evitar las dificultades en el manejo de las redundancias encontradas dentro de las imágenes, y las regiones cercanas mostraban muchas similitudes.

TiTok, que utiliza IA, promete resolver este problema mediante el uso de tecnologías que tokenizan efectivamente imágenes en secuencias latentes 1D para proporcionar una «representación latente compacta» y eliminar la redundancia de regiones.

Además, la estrategia de tokenización podría ayudar a optimizar el almacenamiento de imágenes en plataformas blockchain y, al mismo tiempo, ofrecer mejoras notables en la velocidad de procesamiento.

Además, cuenta con velocidades hasta 410 veces más rápidas que las tecnologías actuales, lo que supone un gran paso adelante en la eficiencia computacional.